Die Verordnung stuft KI-Anwendungen in verschiedene Risikoklassen ein, mit denen jeweils unterschiedliche Auflagen und Verpflichtungen einhergehen. Lesen Sie, wer vom AI Act betroffen ist, welche Anforderungen er mit sich bringt und wie der aktuelle Stand ist.

Wen betrifft der AI Act?

Die Regularien des AI Acts gelten für:

- Anbieter (auch aus Drittländern), die ihre entwickelten KI-Systeme in der EU in Verkehr bringen oder in Betrieb nehmen

- Importeure

- Betreiber

- Distributoren

- Nutzer von KI-Systemen, die sich innerhalb der EU befinden

- Anbieter & Nutzer, die in einem Drittland ansässig sind, wenn der durch ein KI-System erzeugte Output in der EU verwendet wird

Welche Risikoklassen enthält der AI Act?

Der AI Act teilt KI-Systeme in 4 verschiedene Risikoklassen ein, die mit unterschiedlichen rechtlichen Auflagen verbunden sind:

Dabei gilt: Je höher das potenzielle Risiko, das mit dem Einsatz eines KI-Systems einhergeht, desto umfangreicher sind auch die damit verbundenen Auflagen, wie beispielsweise Risikobewertungen, Dokumentationspflichten, EU-Konformitätserklärungen oder Monitoring auf Betreiberseite.

Der AI Act & weitere Regulierungen

Neben der allgemeinen Regulierung durch den AI Act gibt es bereits – und wird es – sektorspezifische Regulierungen geben, die risikobasiert zusätzliche oder andere Maßnahmen verlangen, wie beispielsweise die Maschinenrichtlinie für industrielle Anlagen, die UN ECE Richtlinien Cybersecurity Automotive für Kraftfahrzeuge oder die MDR für KI-unterstützte Maschinen im Bereich Healthcare.

KI-Systeme mit inakzeptablem Risiko

KI-Systeme, die in diese Risikoklasse fallen, werden gemäß AI Act künftig verboten. Denn sie bergen ein erhebliches Potenzial zur Verletzung von Menschenrechten oder Grundprinzipien.

Hierzu zählen Anwendungen, die

- Menschen durch unterschwellige Techniken manipulieren oder ihnen körperlich bzw. physisch schaden könnten,

- Schwächen von bestimmten Personengruppen aufgrund ihres Alters oder von körperlichen sowie geistigen Beeinträchtigungen ausnutzen, um diese bewusst zu beeinflussen,

- Beurteilungen oder Einstufungen der Vertrauenswürdigkeit von Personen über einen bestimmten Zeitraum hinweg auf der Grundlage ihres Sozialverhaltens oder persönlichkeitsbezogener Merkmale vornehmen, die zu einer nachteiligen sozialen Bewertung führen könnten oder

- eine biometrische Identifizierung von Menschen in öffentlich zugänglichen Räumen in Echtzeit aus der Ferne heraus erlauben (Ausnahme: Strafverfolgung)

KI-Systeme mit hohem Risiko

Eine Anwendung gilt als Hochrisiko-KI-System, wenn sie ein potenziell hohes Risiko für die Gesundheit, die Sicherheit oder die Grundrechte von Personen darstellt. Systeme, die hierunter fallen, sind zum Beispiel:

- KI-Systeme, die für die biometrische Identifikation von Personen verwendet werden,

- KI-Systeme, die Rückschlüsse auf persönliche Merkmale von Personen vornehmen, einschließlich Emotionserkennungssystemen,

- Systeme, die für die Verwaltung & den Betrieb von kritischen Infrastrukturen eingesetzt werden,

- KI-Systeme für die Bildung oder Ausbildung mit Bezug auf Bewertung & Beurteilung von Prüfungen & Bildungsniveau sowie

- KI-Systeme, die das Screening oder Filtern von Bewerbungen oder Änderungen des Arbeitsverhältnisses oder Aufgabenzuweisung betreffen

Pflichten, die mit Hochrisiko-KI-Systemen verbunden sind, sind unter anderem:

- Einrichtung, Umsetzung & Dokumentation eines Risikomanagementsystems

- Einhaltung von Anforderungen an die Datenverwaltung & das Datenmanagement, insbesondere mit Blick auf Trainings-, Validierungs- und Testdatensätze

- Erstellung & regelmäßige Aktualisierung der technischen Unterlagen (Technische Dokumentation)

- Aufzeichnungspflicht von Ereignissen („Logs“) & Protokollierung

- Transparenz & Bereitstellung von Informationen für Nutzer:innen

- Überwachung durch menschliches Personal

- Erfüllung eines angemessenen Maßes an Genauigkeit, Robustheit & Cybersicherheit. Im Falle der Verwendung privater Daten oder der Verwendung in Umgebungen kritischer Infrastrukturen gemäß NIS2 sind organisatorische und technische Cybersicherheits-Maßnahmen nach Stand der Technik zu implementieren.

KI-Systeme mit begrenztem Risiko

Zu den Anwendungen, die ein begrenztes Risiko aufweisen, gehören KI-Systeme, die mit Menschen interagieren. Beispiele hierfür sind Emotionserkennungssysteme oder biometrische Kategorisierungssysteme. Hinsichtlich dieser müssen Anbieter sicherstellen, dass natürliche Personen darüber informiert werden, dass sie mit einem KI-System interagieren bzw. muss dies für Anwender:innen durch den Kontext ersichtlich sein.

KI-Systeme mit niedrigem Risiko

Für Anwendungen, die in die Risikoklasse „Niedrig“ fallen, sind derzeit keine rechtlichen Anforderungen vorgesehen. Hierzu zählen zum Beispiel Spamfilter oder Systeme im Bereich Predictive Maintenance.

Um allerdings als Anwendung mit niedrigem Risiko eingestuft zu werden, sind eine technische Dokumentation sowie eine Risikobewertung notwendig.

Strafen bei Verstößen

Bei Nichteinhaltung des Verbotes eines KI-Systems (Artikel 5) oder bei Nichtkonformität mit den definierten Anforderungen (Artikel 10) drohen Geldbußen von bis zu 35 Millionen Euro oder von bis zu 7 % des gesamten weltweiten Jahresumsatzes.

Der Verstoß gegen im AI Act festgelegte Anforderungen und Verpflichtungen – mit Ausnahme von Artikel 5 & 10 – wird mit Geldbußen in Höhe von bis zu 15 Millionen Euro oder von bis zu 3 % des gesamten weltweiten Jahresumsatzes bestraft.

Die Angabe von falschen, unvollständigen oder irreführenden Informationen gegenüber den benannten Stellen und zuständigen nationalen Behörden wird mit Bußgeldern in Höhe von 7,5 Millionen Euro oder von bis zu 1,5 % des gesamten weltweiten Jahresumsatzes geahndet.

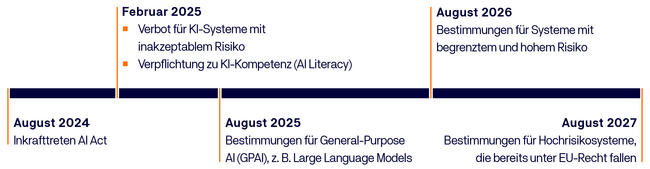

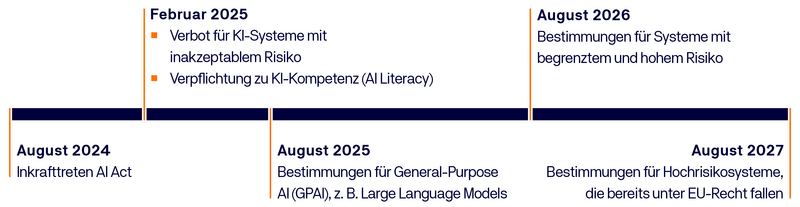

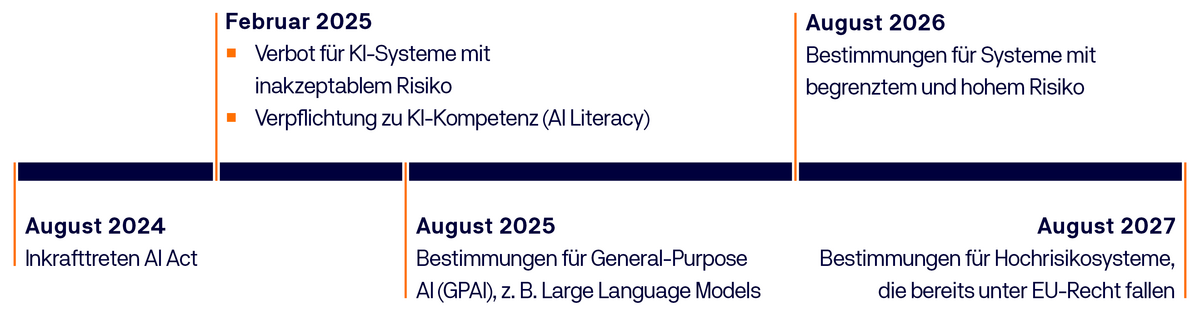

Wie ist der aktuelle Stand des AI Acts?

Der AI Act trat im August 2024 in Kraft und wird Schritt für Schritt umgesetzt.

Wie können sich Unternehmen schon heute auf den AI Act vorbereiten?

Verantwortlichkeiten benennen

Auch wenn der AI Act noch nicht offiziell verabschiedet ist, ist es für Unternehmen durchaus sinnvoll, sich schon frühzeitig mit den kommenden Anforderungen auseinanderzusetzen. Hier empfiehlt es sich, von Anfang an entsprechende Verantwortlichkeiten festzulegen. Auf diese Weise können bereits vorsorgliche Regelungen getroffen werden, wie mit Neuentwicklungen, oder dem Einkauf von KI-Anwendungen oder deren Nutzung perspektivisch umgegangen werden soll.

Gap-Analyse & Maßahmeplan

Um den aktuellen Status quo hinsichtlich der Umsetzung des AI Acts zu bestimmen, bietet sich die Durchführung einer Gap-Analyse an. Darauf aufbauend kann in einem nächsten Schritt ein Maßnahmenplan erarbeitet werden. In diesem Kontext ist es für Unternehmen zudem wichtig, in Erfahrung zu bringen, welche KI-Anwendungen und Lösungen überhaupt im Einsatz sind und welcher der verschiedenen Risikokategorien diese zuzuordnen sind. Aus dieser Kategorisierung ergeben sich dann die grundlegenden Anforderungen, die es zu beachten gilt.

KI-Sicherheit von Anfang an mitdenken

Die KI-Expert:innen von TÜVIT stehen Unternehmen bereits im Rahmen der Entwicklung von KI-Systemen unterstützend zur Seite, um die Aspekte Sicherheit, Robustheit und Transparenz von Anfang an zu berücksichtigen. Darüber hinaus führen sie Gap-Analysen sowie weitere detaillierte Analysen (z.B. in Bezug auf das Modelldesign) durch und bieten Sicherheitsprüfungen mit spezieller Testsoftware an. Bestmöglich bereiten sich Unternehmen auf die kommenden Anforderungen vor, indem sie die Sicherheitseigenschaften ihrer KI-Lösung durch einen unabhängigen Dritten prüfen und/oder zertifizieren lassen. Dies ist aktuell zum Beispiel nach dem TÜVIT-eigenen Trusted Product Schema möglich.

Kontinuierliche Überwachung

Darüber hinaus ist es ratsam, kontinuierlich zu überwachen, ob neue KI-Anwendungen hinzukommen oder sich gesetzliche Änderungen ergeben.

Finaler Entwurf des AI Acts

Die Informationen auf dieser Seite beruhen auf dem endgültigen Entwurf des Ai Acts. Diesen finden Sie auf der offiziellen Website des Europäischen Parlaments.